2017: Der Computer als Denkzeug.

Abstract

Dies ist das Vortragsmanuskript. Das gesprochene Wort kann abweichen.

Der Computer als Denkzeug

Ein Denkzeug ist das Werkzeug der Instrumentellen Vernunft.

Sie wissen schon, wenn Sie einen Hammer in der Hand halten, sehen alle Probleme plötzlich wie Nägel aus. Ebenso ist ein Teil des Gebrauchs unseres Verstandes instrumenteller Natur: Ich denke, um zu.., ich handle, um zu.., und für diesen Teil sind moderne informationstechnische Systeme das perfekte Werkzeug. Allerdings merken wir nicht, wie sehr diese unser Denken einschränken, wenn wir die Systeme nicht verstehen.

Das instrumentelle Wesen des Faustkeils ist sofort ersichtlich. Die Designerinnen und Designer haben ganz offensichtlich eng mit den Nutzerinnen und Nutzern bei diesem Entwurf zusammengearbeitet. Scharfkantig und spitz ist die Seite, die der handschmeichelnden Rundung entgegengesetzt ist, man nimmt den Faustkeil intuitiv richtig in die Hand, um etwas zu schneiden, zu durchbohren, abzuschaben. Technik, die begeistert.

Der homo faber nutzt nicht nur Werkeuge, er kreiert sie, um mit ihnen wiederum etwas Neues zu erschaffen, was es so in der Natur nicht gab. Jedes Produzieren ist Techniknutzung, jede Techniknutzung bringt etwas hervor (und sei es nur Abwärme). Es gab in den letzten Jahren allerdings eine Verschiebung in der Bedeutung der Begriffe »Nutzung« und »Nutzer«, so sprechen wir ja beispielsweise von Facebook-Nutzern, obwohl sie intern in der Datenbank als »Targets«, also Zielgruppe bezeichnet werden. Wir sagen auch, dass wir Suchmaschinen nutzen, obwohl es sich aus Firmensicht nur um Dateneingaben handelt.

Die Nutzerinnen und Nutzer haben irgendwann in den letzen zehn, fünfzehn Jahren ihre informationelle Hoheit verloren und sind nur noch Benutzte (im Englischen gibt es die schöne Unterscheidung von »user« und »usee«). Höchste Zeit also, über die technischen Bedingungen der Wiedererlangung der Digitalen Mündigkeit zu diskutieren, Begriffe wie »Produsage« oder die älteren »user generated content«, »Web 2.0« oder »read-write-culture« deuten ja auf eine Sensibiliserung in diesem Bereich hin.

Die uns jederzeit und ständig zur Verfügung stehende Informations- und Kommunikationstechnik wird zwar genutzt, aber nicht verstanden, sie wird mystifiziert oder verteufelt – auch von uns Informatikerinnen und Informatikern, wenn wir mit Nicht-Technikern sprechen. Wir sind gute Gebrauchtwagenhändler, Sie schauen ja sowieso nicht unter die Haube, ihr Öl wechseln Sie sicher auch nicht selbst.

Ein simples Beispiel soll diese Behauptung stützen: Nehmen Sie das Navigationssystem im Auto. Jedes Navi besitzt ein GPS-Modul, GPS steht für Global Positioning System, mit dessen Hilfe man die Längen- und Breitengrade der eigenen Position bestimmen kann. In einer Diskussion zur Überwachungsdebatte vertrat ein so genannter Technikphilosoph die Meinung, die Satelliten im All würden nun seine Position kennen, er sei durch GPS völlig überwacht. Dabei ist er es, der mit Hilfe des Navis die Position der Satelliten nun kennt. Die Sterne wissen ja auch nicht, wo der Sextant ist, sondern der Sextant, wo die Sterne sind, daraus berechnet der Navigator dann seine eigene Position.

Im Navigationsgerät steckt allerdings meistens auch noch ein Funk- oder Telefonmodul, das die Positionsdaten durchaus einem Satelliten und dessen Betreiber verraten könnte. Die Angst vor Überwachung ist also berechtigt, aber technisch ungenügend begründet gewesen. Ich möchte mit diesem Vortrag Ihren Blick auf technische Details lenken.

Ich möchte heute über das Spannungsfeld Technikutilisation und Technikproduktion sprechen und dafür in typischer Informatik-Manier durch die Disziplinen trampeln und mit jedem Schritt hunderte von Jahren nehmen. Das ist mir erlaubt, weil die Informatik ja nach wie vor als junge wissenschaftliche Disziplin gilt, vielleicht auch, weil nach wie vor der Irrglaube herrscht, wir hätten etwas mit Computern zu tun. Naja, irgendwie haben wir schon etwas mit Computern zu tun, aber eher in der Art wie ein Astronom etwas mit dem Fernrohr zu tun hat. Es ist ein Mittel zum Zweck. Zugegeben, Astronomen lieben es, über Fernrohre und Beobachtungstechniken zu sprechen – die gesellschaftlichen Veränderungen setzten und setzen jedoch die Beobachtungen selbst in Gang.

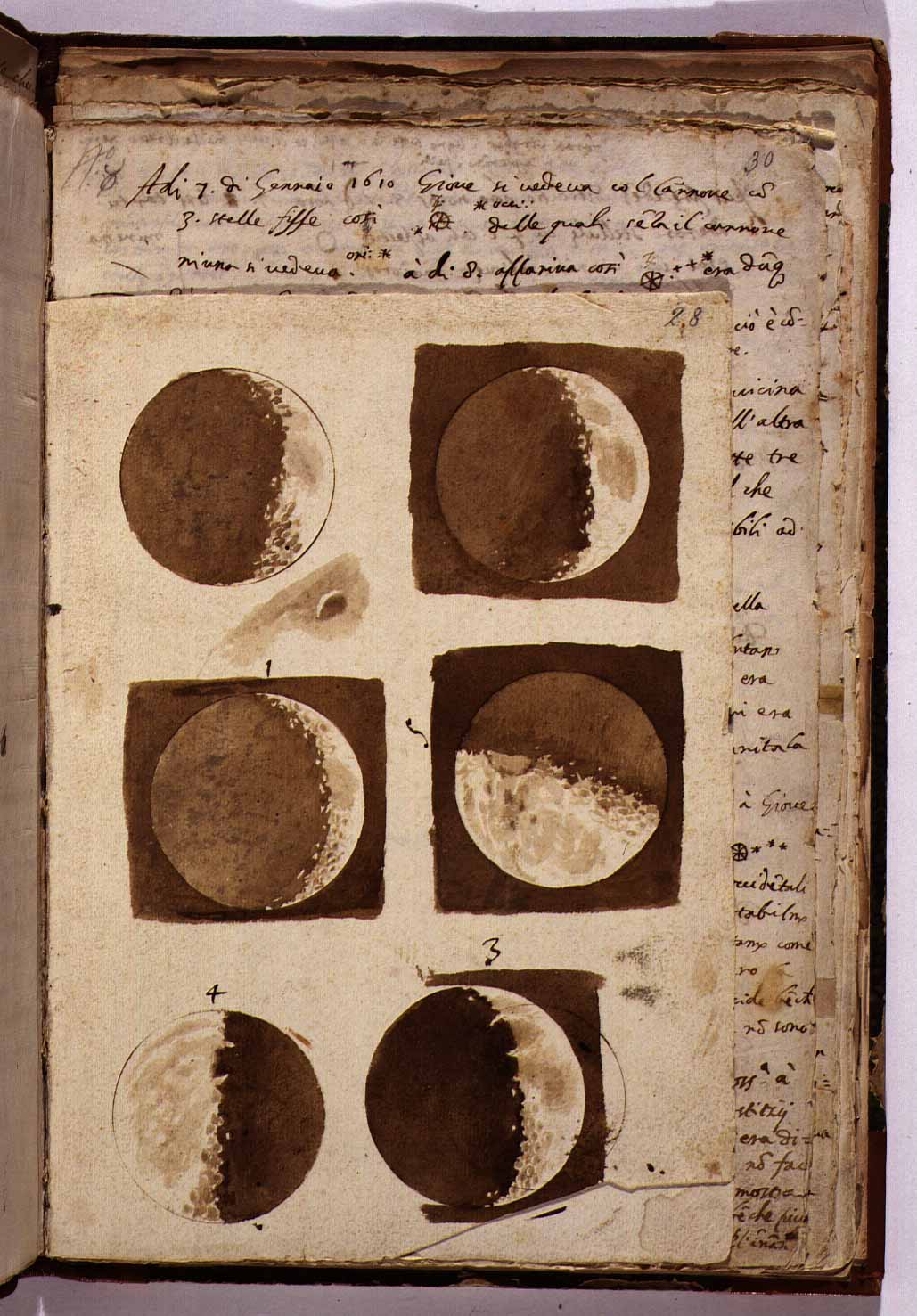

Galileo Galilei fertigte die Zeichnung nach der Beobachtung des Mondes durch ein zu seiner Zeit bislang unbekanntes Instrument hindurch: Das Teleskop. Doch wie später mit dem Computer, so sollte der wahre Wert des Fernrohrs zunächst verkannt werden. Vielleicht trug es sich nicht so zu, wie es im Theaterstück von Bertolt Brecht beschrieben wurde, doch man kann sich gut vorstellen, was passiert, wenn Venedigs Venture Capitalists und CEOs ein neues technisches Instrument in den Händen halten. Sie werden natürlich begeistert sein, einfach, weil sie das Fernrohr auf durchaus weltliche Dinge gelenkt haben, speisende und badende Frauen, und sich über den unerwarteten Datenreichtum freuen.

Galileo wird die Freude trüben, denn obwohl er die holländische Erfindung nach christlichen Grundsätzen verbessert haben will, so stellt er doch kirchliche Dogmen fundamental in Frage. Der Mond war keine perfekte, leuchtende Kugel, sondern pockennarbig mit Tälern und Bergen. Was der Mond der Erde, ist die Erde dem Mond.

Die Verurteilung des Galilei fiel in das Pontifikat von Papst Urban VIII., Jesuit und doctor iurisprudentiae, der zwar ein Freund der Wissenschaft und der Kunst war, sich jedoch nicht gegen die mächtige Inquisition stellen konnte. Im Theaterstück von Brecht versucht der Papst, die Wissenschaft, namentlich Sternenkarte und Rechentafel zu verteidigen, der Inquisitor jedoch erwiderte:

Daß es die Rechentafel ist und nicht der Geist der Auflehnung und des Zweifels, das sagen diese Leute. Aber es ist nicht die Rechentafel. Sondern eine entsetzliche Unruhe ist in die Welt gekommen. Es ist die Unruhe ihres eigenen Gehirns, die diese auf die unbewegliche Erde übertragen. Sie schreien: die Zahlen zwingen uns! Aber woher kommen ihre Zahlen? Jedermann weiß, daß sie vom Zweifel kommen.

In dieser Logik sei das Teleskop also ein Produkt des Zweifels und so verwundert es nicht, dass man alles in Frage stellt, was man damit sieht. Der Zweifel selbst sei quasi eingebrannt in die Hardware. Das ist eine frühe Formulierung des nach wie vor aktuellen Problems:

Angenommen, wir gelangen durch ein Instrument an Daten, so müssen wir zur Überprüfung dieser Daten wieder auf das Instrument zurückgreifen. Ob wir dem Instrument vertrauen oder nicht ist eine fundamental epistemologische Frage.

Ganz von der Hand zu weisen ist das Argument des Inquisitors sicherlich nicht. Neue Erkenntnisse, besonders auf technischem Gebiet, werfen stets neue Zweifel an vorherrschenden Welt- und Menschenbildern auf. Gerade technische Artefakte zeigen auf den Hersteller solcher Artefakte. Ecce Homo. Acker- und Bergbau führte zum Bild des Menschen als aus Erde geformtes Wesen bzw. als ein tönendes Erz, der Descarte’sche Homunculus blickt von der Zirbeldrüse durch geschliffene Linsen auf die Welt und inzwischen ist den Informatikerinnen und Informatikern ja klar, dass das menschliche Gehirn nur ein Supercomputer sei, das wahrlich ein paar security software updates nötig hätte.

Doch ich möchte hier nicht über den größenwahnsinnigen Zweig »Künstliche Intelligenz und Transhumanismus« sprechen (vielleicht in der Diskussion), sondern über den Computer als Werkzeug für das Denken. Die ersten Vorläufer des Computers bei Leibniz oder Babbage waren reine Rechenmaschinen. Mathematisch formulierbare Probleme eines bestimmten Typs können mit einer solchen Maschine gelöst werden, also in eine Reihe von Zahnradbewegungen, Hebelpositionsveränderungen und generell in Status-Wechsel der Maschine übersetzt werden. Am Ende muss ein Mensch aus der Zahnradstellung, Hebelposition bzw. dem endgültig erreichten Status wieder rückübersetzen, was denn das Ergebnis sei.

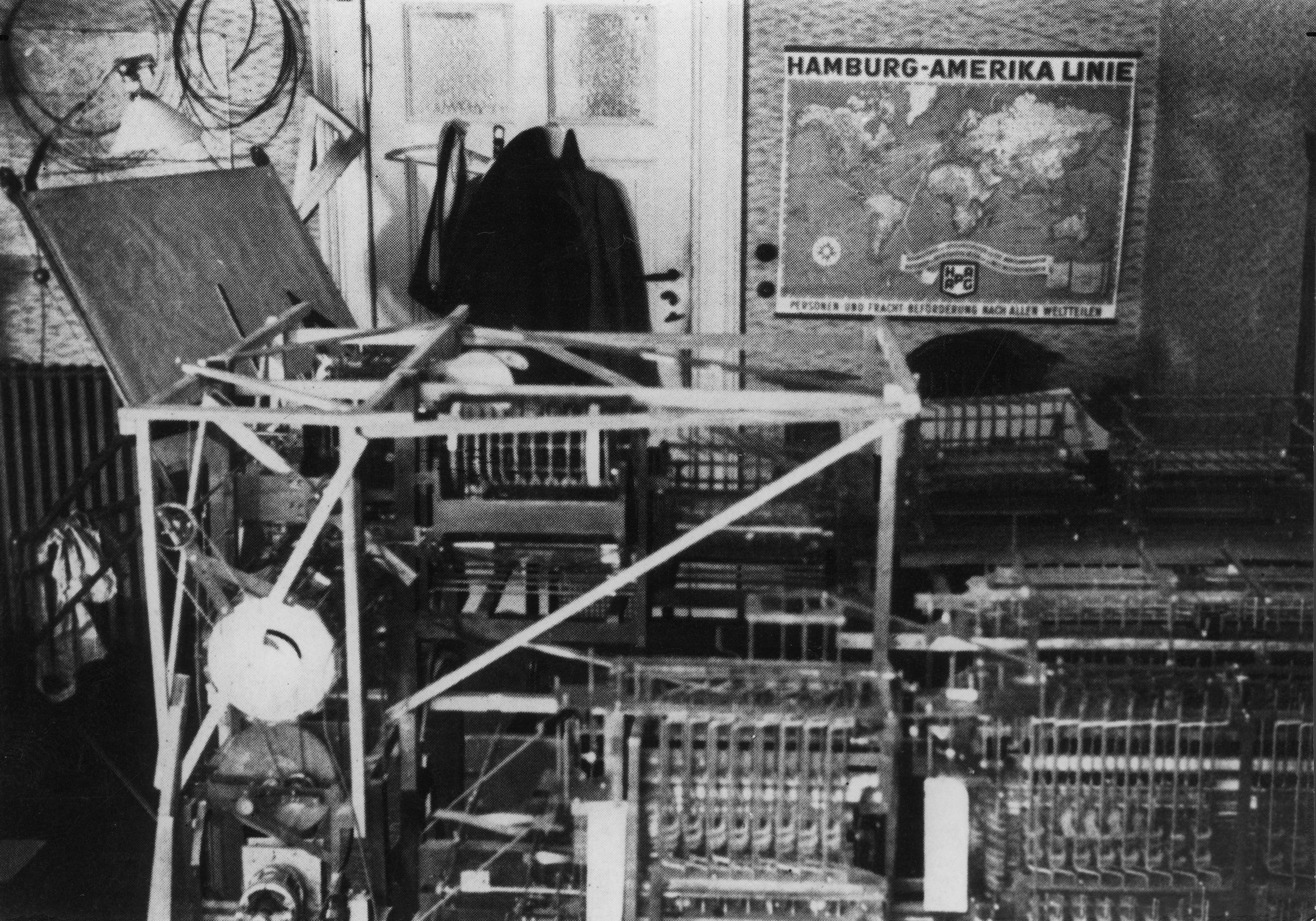

Typische Probleme der mechanischen und elektischen Rechenmaschinen sind arithmetische oder ballistische Berechnungen, hier im Hintergrund sehen Sie die Rechenmaschine Z1 des Deutschen Ingenieurs Konrad Zuse, die im Prinzip eine automatisierte Form des Rechenschiebers darstellte. Wer von Ihnen hat noch mit einem Rechenschieber gerechnet?

Dann werden Sie sicher Konrad Zuses Motivation verstehen, dieses bei komplizierten Berechnungen doch recht mühselige Verfahren zu automatisieren. Im elterlichen Wohnzimmer in Berlin-Kreuzberg sägte er 1936 aus Weichblech mehrere zehntausend Einzelteile aus, die er zur Z1 zusammensetzte, der ersten frei programmierbaren Rechenmaschine der Welt. Wir finden dort alle Bestandteile eines modernen Computersystems, also die zentrale Prozessoreinheit, Speicher, arithmetische Recheneinheit und sogar ein Medienlesegerät, das Lochstreifen einlesen konnte. Die Z1 arbeitete zwar mechanisch, sie war aber kein Analog-Computer, es ist ein bekanntes und weitverbreitetes Missverständnis, dass Analog das Gegenteil von Digital sei.

Ein Rechenschieber ist ein Analog-Computer, die Z1 und ihre Nachfolgerinnen sind binär arbeitende Digitalrechner. Um sie zu programmieren, muss es erst einmal ein Kalkül geben, heute würden wir sagen: Eine Programmiersprache.

Bevor ich mit Ihnen nun tatsächlich eine tieferen Blick in das Innere von Computersystemen werfe, möchte ich Sie beruhigen; Sie müssen die Programmiersprache weder kennen noch verstehen, sondern ganz im Sinne Wilhelm von Humboldts lediglich als Programmiersprache erkennen. Fangen wir vielleicht mit der Spracherkennung an.

Ein sehr grosser Theil der Sprache und ihres Baues kann erkannt werden, ehe man noch zu den einzelnen Lauten herabsteigt, so wenig besteht ihr Wesen in blossen Schällen. Aber diese Schälle sind doch in jeder individuellen die Hauptsache, und ihr Studium darf nicht verschmäht werden. Denn der Mensch kommt nicht nach Art eines reinen Geistes in die Welt, der den fertigen Gedanken nur mit Tönen umkleidet, sondern als ein tönendes Erdengeschöpf, aus dessen Tönen sich aber, nach ihrer wundervollen Natur, durch ein in ihrem scheinbar zufälligen Gewirr ruhendes System alles Grosse, Reine und Geistige entwickelt.

Die Humboldt’schen Schälle sind die Realisationen der Rede im vierdimensionalen Raum. Diese Realisation ist einigen Einschränkungen unterworfen, manchmal gibt es originelle Versuche, die Limitationen der Umwelt zu überwinden, denken Sie an die gepfiffenen Sprachen, die kilometerweit über tiefe Täler hinweg zu hören sind, wie das Silbo Gomero.

In der Programmierung haben wir ähnliche Limitationen, ich möchte Ihnen hier ein paar zeigen mit dem Fokus darauf, wie dies unser Denken tatsächlich beeinflusst. Wenn ich »unser« schreibe meine ich damit uns Informatikerinnen und Informatiker einerseits, aber auch uns Nutzerinnen und Nutzer informationstechnischer Systeme andererseits.

Angenommen, wir haben ein kontinuierliches Signal vorliegen, etwa eine Audio-Aufnahme, hier dargestellt als Schallwelle. In diesem Ausschnitt aus Prokofjews »Peter und der Wolf« werden die Protagonisten und ihre Instrumente vorgestellt. Der linke Teil der Waveform entspricht dem detuschen Satz: »Der Wolf wird von drei Hörnern gespielt«, der rechte Teil den drei Hörnern, vielleicht sehen Sie den Unterschied.

Die grundsätzlichste Limitation aller Computersysteme: Egal wie universell sie sind, am Ende sind sie Symboltransformationsmaschinen. Wir benötigen also in erster Linie ein diskretes Symbol oder eine Abfolge von diskreten Symbolen.

Die kontinuierliche Schallwelle muss für die Digitalisierung nun »abgetastet« werden, dabei gehen Informationen zwangsläufig verloren. Wie viel verloren geht, hängt von den Sensoren und der Abtastfrequenz ab und vom dahinter liegenden Modell.

In einem ersten Schritt für die Spracherkennung muss die Software zwischen Sprache und anderen Lauten unterscheiden, dann die Wörter oder gar Silben identifizieren und schließlich in einen Text übersetzen. Bei diesem Übersetzungsprozess geht wieder eine Menge verloren, Ihnen muss ich ja nicht den Unterschied zwischen gesprochener Rede und gedrucktem Text erklären. Mit dem digitalisierten Text, also der Kette aus diskreten Symbolen, kann das informationstechnische System weitaus besser und vor allem schneller umgehen als mit den unprozessierten Rohdaten.

Mit wissenschaftlicher Sorgfalt müsste an dieser Stelle der Kontext mit gespeichert werden, also wenigstens die Betonung mitspeichern, persönliche Daten der Sprecherin oder des Sprechers, Alter beispielsweise, Ort und Datum der Äußerung et cetera. Denn nehmen Sie nur mal die Proposition p := »Ich bin ein schlechter Mensch«. Luther meinte damit, dass er ein einfacher, geradliniger Kerl sei, im Sinne des heutigen »schlicht«. Gut, da liegen 500 Jahre dazwischen, aber schon in 25 Jahren kann einiges geschehen, unterhalten Sie sich mal mit Ihren Großnichten oder Enkeln oder schnappen Sie ein paar Wortfetzen vor einem Schulgebäude auf.

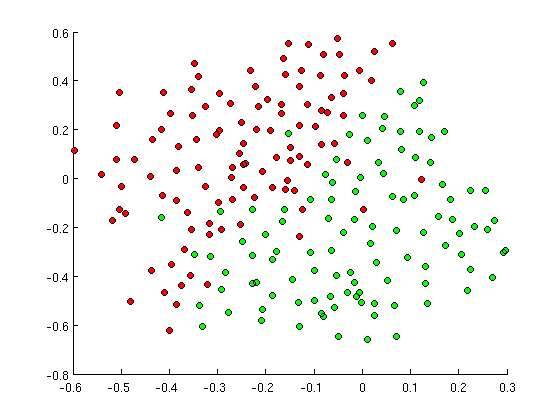

Die Klassifikation ist ein anderes Grundproblem der Informatik. Hier auf dem Bild können Sie die roten und grünen Punkte wohl mehr erahnen als tatsächlich sehen, sie sollen für zwei verschiedene Klassen stehen. Wenn Sie nun einen neuen Datenpunkt messen oder anderweitig bekommen, sollen Sie mit Hilfe eines Computersystems entscheiden, ob er nun zur Klasse »rot« oder »grün« gehört.

Nun gibt es prinzipiell zwei Arbeitsmodi für das Klassifikationsverfahren: Algorithmisch oder heuristisch. In den Anfängen des Computerzeitalters konzentrierte man sich auf die Algorithmen, man musste ein zu berechnendes Problem also zutiefst verstanden haben, bevor man es in den Computer eingeben konnte. (Bzw. dem Computer übergeben konnte, denn unter Computer verstand man lange Zeit die Männer und Frauen, die vor einer riesigen Maschinenwand die Kabel entsprechend verlegten.) Man versucht, die zugrunde liegende Kausalität mehr oder weniger zu entbergen.

Je nach Zeit- und Rechenkapazitäten sind unter Umständen auch Näherungen gewünscht, etwa bei der Biometrie, die ja in wenigen Sekunden eine Klassifikation vornehmen soll. Hier sehen Sie drei Trenngeraden von drei Stützvektorenklassifizierungen. Die Klassenzugehörigkeit wird hier über die Nähe der Punkte zueinander bestimmt, entweder nur zum jeweils nächsten Nachbarn oder zu den k Nachbarn. Je genauer die Trenngerade, desto länger die Berechnung – fehlerhafte Zuordnungen gibt es aber in beiden Fällen.

Die Fehlerraten im Bereich der Biometrie sind übrigens so hoch, dass Firmen die entsprechenden Studienergebnisse lieber nicht veröffentlichen, selbst staatsnahe Firmen (wie die Österreichische Staatsdruckerei oder die deutsche Bundesdruckerei) geben nur widerwillig Auskunft über die Erkennungsraten von biometrischen Systemen, meine Kollegin Andrea Knaut kann davon ein Lied singen. Im Falle von Deutschland gibt es immerhin die »BioP II«-Studie »Untersuchung der Leistungsfähigkeit von biometrischen Verifikationssystemen«.

In Deutschland wurde, wie hier in Österreich auch, der neue Reisepass mit auf einem Funk-Chip gespeicherten biometrischen Daten vorgestellt und am Frankfurter Flughafen getestet. Es gab vier Systeme, die mit Schulnoten bewertet wurden: Wenn es innerhalb des Feldtests weniger als 16 Totalausfälle gab, die biometrische Erkennung 8 Sekunden oder weniger dauerte, nur in einem von hundert Fällen fehlerhafte Klassifikatione vorgenommen wurde, dann gab es eine glatte 1, sehr gut, mit Auszeichnung. Immerhin ausreichend, also bestanden, gab es für 64 Totalausfälle, 14 Sekunden Bedienzeit, vier Prozent Fehler.

Und nun die Ergebnisse: Ausreichend, Befriedigend, Befriedigend, Ausreichend. Wenn Sie jetzt allerdings auf technische Details und Zahlen gehofft haben, so werden Sie auf Seite 133 enttäuscht. Zitat:

»Auf eine detaillierte Darstellung der Ergebnisse wird in diesem Bericht verzichtet.«

Wie schlimm es um biometrische Erkennungssysteme bestellt ist, zeigten im Oktober 2016 Forscherinnen und Forscher der Carnegie Mellon University, Pittsburgh. Sie druckten sich bunte Plastikbrillen aus und wurden prompt vom biometrischen System erkannt, allerdings als falsche Person, wie Sie sehen. Wenn Sie also wie Milla Jovovich aussehen wollen, brauchen Sie nur eine bunte Brille.

Nach den algorithmischen Lösungen sind heuristische Verfahren zur Zeit in aller Munde, besonders der ganze Bereich des Maschinellen Lernens. »Machine Learning«, »Neuronale Netzwerke« – das klingt ziemlich anthropomorph, wie »Elektronengehirn« oder »Künstliche Intelligenz«.

Es hört sich zweifelsohne besser an als Statistik, dabei geht es im Kern des maschinellen Lernens um Wahrscheinlichkeiten und Häufungen von Ereignissen – und eben nicht um Kausalitäten oder Verständnis des vorliegenden Problems. Nehmen wir mal als Aufgabe, aus einem Labyrinth herauszufinden. Es gibt einen ganz einfachen Algorithmus: Berühren Sie stets mit einer Hand eine Wand und gehen Sie so lange weiter, bis Sie den Ausgang finden.

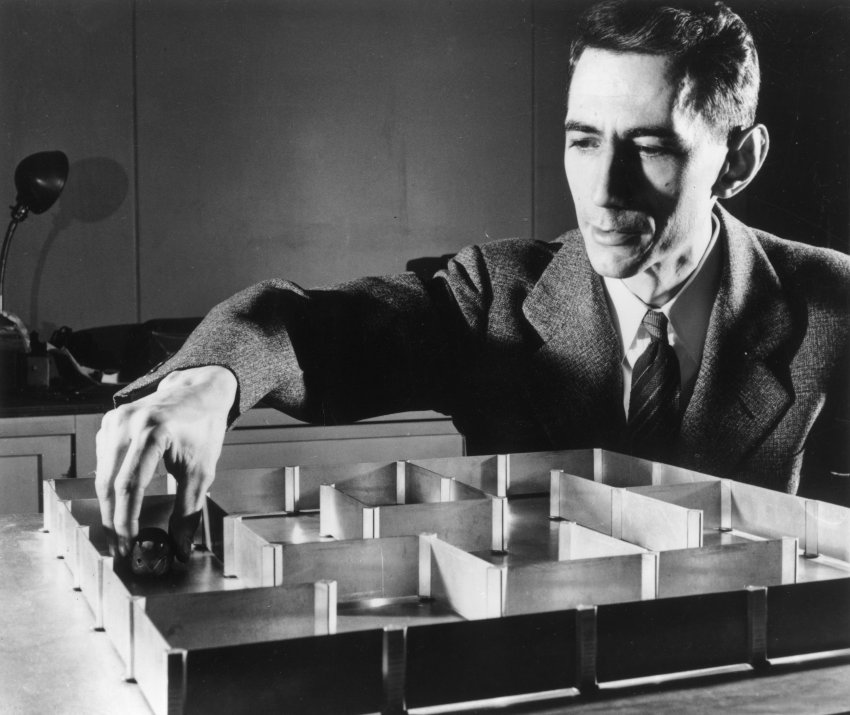

Der vor 101 Jahren geborene Claude Shannon war Elektrotechniker, Mathematiker und Begründer der Informationswissenschaft, auf ihn geht der Begriff bit (binary digit) für die Einheit der Information zurück – ihm ist die algorithmische Lösung des Labyrinthproblems wohlbekannt. Er kreierte dennoch eine Robotermaus, die zufällige Bewegungen ausführen sollte, um einen Weg durch den Irrgarten zu finden. Hinterher wurde ihr ein Score, eine Bewertung mitgeteilt, wie gut sie abgeschnitten hat. Aus dieser Erfahrung mit der entsprechenden Bewertung wurde die Aufgabe erneut ausgeführt, diesmal hatte die Maus aber etwas »gelernt« und schnitt entsprechend besser ab.

Das muss, wie gesagt, für einen allwissenden außenstehenden Beobachter nicht sinnvoll sein, ich meine, Sie reiben ja auch die Münzen am Fahrkartenautomaten, wenn sie nicht angenommen werden. Das ist ja vollkommener Quatsch, aber meistens klappt es dann ja doch mit der Münze, der Score ist entsprechend hoch und aus diesen Experiences wird dann eine entsprechende Handlung abgeleitet.

Sie als Individuum können natürlich lernen, aber auch der Mensch an sich kann »lernen«, denken Sie an die Evolution. Unsere Kinder sind keine Klone ihrer Eltern, sondern Rekombinationen ihrer Erbinformationen, Zufälle und Mutationen haben die Menschen bis heute überleben lassen. Der Score der Erbgutweitergabe ist binär, etweder gibt man sein Erbgut weiter oder eben nicht. Das maschinelle Lernen können Sie sich wie eine Evolution im Zeitraffer vorstellen, erfolgreiche Strategien werden von der nächsten Programmgeneration übernommen.

[…]

Ziemlich genau 60km östlich von hier wurde 1955 der erste Volltransistorrechner Europas gebaut, ein halb illegales Unterfangen eines kleinen Hochschulassistenten. Der Computer- und Informatikpionier Heinz Zemanek studierte, arbeitete und lebte bis zu seinem Tod vor knapp drei Jahren in Wien. Zemanek betonte immer das »T« in »TU Wien«, er habe an der Technischen Hochschule bzw. später dann Universität gewirkt.

Auf der Folie hinter mir sehen Sie das Kontrollpult des von ihm konstruierten »Mailüfterls«, bestehend aus 3000 Transistoren, 15k Widerständen und 20 Kilometern Draht. Dreitausend Transistoren mögen wenig erscheinen, heute sind auf einer einzigen Gamer-Grafikkarte ungefähr 7 Milliarden verbaut, aber wenn Sie bedenken, dass der Transistor erst wenige Jahre zuvor auf den Markt kam, ist das schon eine beachtliche Leistung, zumal in der pecuniär prekären Academia. Die Transistoren wurden letztlich von Philips nach persönlicher Vorsprache gespendet.

Wenn Sie vor einem 4 mal 2 Meter großen Schrank mit einem Haufen Draht und Elektronik stehen, merken Sie, dass ohne Software, ohne Ein- und Ausgaben nichts weiter passiert. Der Schrank steht erst einmal nur da. Zemanek und sein Team, die später das Wiener IBM-Labor mitgründeten, mussten also auch Software, eben Betriebssystem und Programmiersprache entwickeln. Wer Computersysteme auf dieser basalen Ebene betrachten kann, entwickelt einen enormen Respekt. Nicht vor der Maschine, dem dummen Ding. Vor den Technikerinnen und Technikern, die mit dazu betrugen, das komplexeste, umfangreichste und bislang ambitionierteste Artefakt der Menschheit zu erschaffen: Die Digitale Natur.

Wer auf dieser basalen Ebene die Informationstechnischen Systeme betrachtet, entwickelt eine Demut, die sich auch in den Ethischen Selbstverpflichtungen der Nachkriegs-Ingenieure widerspiegelt:

»Der Ingenieur übe seinen Beruf aus in Ehrfurcht vor den Werten jenseits von Wissen und Erkennen und in Demut vor der Allmacht, die über seinem Erdendasein waltet. Der Ingenieur stelle seine Berufsarbeit in den Dienste der Menschheit und wahre im Beruf die gleichen Grundsätze der Ehrenhaftigkeit, Gerechtigkeit und Unparteilichkeit, die für alle Menschen Gesetz sind.«

So das feierliche Bekenntnis des Ingenieurs von 1950, vorgetragen auf der Hauptversammlung des Verbandes Deutscher Ingenieure. Die über jedem waltende Allmacht kann man religiös oder spirituell interpretieren, aber viel offensichtlicher sind es doch die Technischen Zwänge, die über alle Menschen walten.

(– und hier führe ich nun hoffentlich alle offenen Enden zusammen und komme auf meinen Titel »Der Computer als Denkzeug zurück«. 20.000 Meter Draht, 20.000 Zeichen, das ist wohl zu schaffen.)

Zum Schluss, dies ist meine letzte Folie, möchte ich den Einfluss der informationstechnischen Systeme auf unsere Sprache beleuchten. Dahinter liegt natürlich die Annahme, dass Sprache unser Denken formt oder zumindest so eng mit dem Denken verknüpft ist, dass wir vom Gebrauch der einen auf den Gebrauch des anderen schließen können – und umgekehrt.

Ich möchte das nicht mit Humboldt oder Orwell zeigen, sondern auf Heinz Zemanek verweisen, der bedenkliche Sprach-Entwicklungen bereits in den 1980er Jahren in seiner Vorlesung zum geistigen Umfeld der Informationstechnik feststellte. Im folgenden sind seine Gedanken widergegeben, ich verzichte allerdings auf den Konjunktiv der indirekten Rede, damit Sie mir besser folgen können.

Die formalen Sprachen informationstechnischer Systeme sind in ihrem speziellen Umfeld der natürlichen Sprache überlegen, wenn Sie Bit zu Bit wandeln und Symbol zu Symbol transformieren. Am Anfang und am Ende des Transformationsprozesses steht jedoch der Mensch mit seiner natürlichen Sprache, die nun Phänomene sehr ungelenk erklären muss.

Beispielsweise retten sich Techniker und Nicht-Techniker gleichermaßen in Drei-Buchstaben-Abkürzungen, die zudem in unterschiedlichen Disziplinen mehrfach besetzt sind, und hoffen, dass niemand nachfragt. Wissen Sie noch, was GPS bedeutet? General Problem Solver oder Grüne Partei Schweiz?

Zweitens gibt es neuartige Zeitwörter, wie »beinhalten« oder »erstellen«, vielleicht können wir auch auch »implementieren«, »realisieren« und »modellieren« dazunehmen.

»Drittens uns schlimmstens: Das Profil der allgemeinen Hauptwörter wird aufgelöst, hauptsächlich durch sorglosen, ungenauen oder falschen Gebrauch, den kaum mehr jemand verhindert, korrigiert oder anprangert.« (S.269, geistiges Umfeld)

Heinz Zemanek, der vor drei Jahren verstorben ist, hätte heute sicher auch noch die inhaltsambivalenten »cloud computing«, »big data« oder natürlich »cyber« angeprangert.

Dies sind also die zwei Einschränkungen im Denken bei der Nutzung des Computers: Nicht nur unsere Hinwendung zur Welt wird durch informationstechnische Systeme beeinflusst, sondern auch die nach innen gerichtete Beantwortung der Frage »Was ist der Mensch«.

Bevor wir als Gesellschaft also den Transhumanismus so eifrig begrüßen, sollten sich zumindest die Technikerinnen und Techniker der Pfelge des Humanismus widmen. Der berühmte Wahspruch von Immanuel Kant ist zu erweitern: Sapere Et Informare Aude! Habe Muth, dich deines eigenen Verstandes mit von dir verstandenen informationstechnischen Systemen zu bedienen. Dann klappt es auch mit der Aufklärung 2.0.

Ich danke Ihnen für Ihre Aufmerksamkeit.